Google avance sur deux fronts technologiques et revendique une nouvelle étape dans l’intelligence artificielle. Avec l’API Interactions, le groupe propose une interface unifiée pour orchestrer modèles, outils et agents autonomes. En parallèle, la Recherche Profonde (Deep Research) est repensée pour gérer des enquêtes web multi-étapes, avec des citations plus fines et une meilleure capacité d’analyse de données. Cette contre-attaque face à OpenAI met l’accent sur l’industrialisation des agents et l’intégration directe dans les produits du quotidien.

Le contexte concurrentiel reste dense. OpenAI a officialisé GPT-5.2 et pousse SearchGPT, tandis que Google connecte ses briques Gemini, renforce l’agentic computing et prépare l’embarquement de Deep Research dans son moteur de recherche. Pour les développeurs, l’enjeu n’est plus de choisir un unique modèle, mais de composer des systèmes fiables, traçables et interopérables. Concrètement, l’API Interactions centralise l’état conversationnel, les appels d’outils via MCP, l’exécution en arrière-plan et la coordination d’agents, avec un déploiement prévu sur Vertex AI pour les environnements régulés. La bataille se joue donc sur la sécurité, la rapidité de mise en œuvre et la preuve d’exactitude. Les entreprises qui sauront exploiter cette nouvelle couche d’orchestration pourront automatiser des tâches complexes, tout en gardant un contrôle strict sur la gouvernance des données et la qualité de la réponse.

- API Interactions : un point d’entrée unique pour modèles Gemini, outils MCP et agents autonomes.

- Recherche Profonde : navigation itérative, citations granulaires et synthèses multi-sources.

- Course Google vs OpenAI : lancements synchronisés, cap sur l’agentic computing et la fiabilité.

- Interopérabilité : support ADK, A2A et gestion d’état côté serveur pour accélérer les mises en production.

- Cas d’usage : audit réglementaire, veille marché, support client, product intelligence et sourcing B2B.

API Interactions de Google : architecture unifiée et orchestration d’agents face à OpenAI

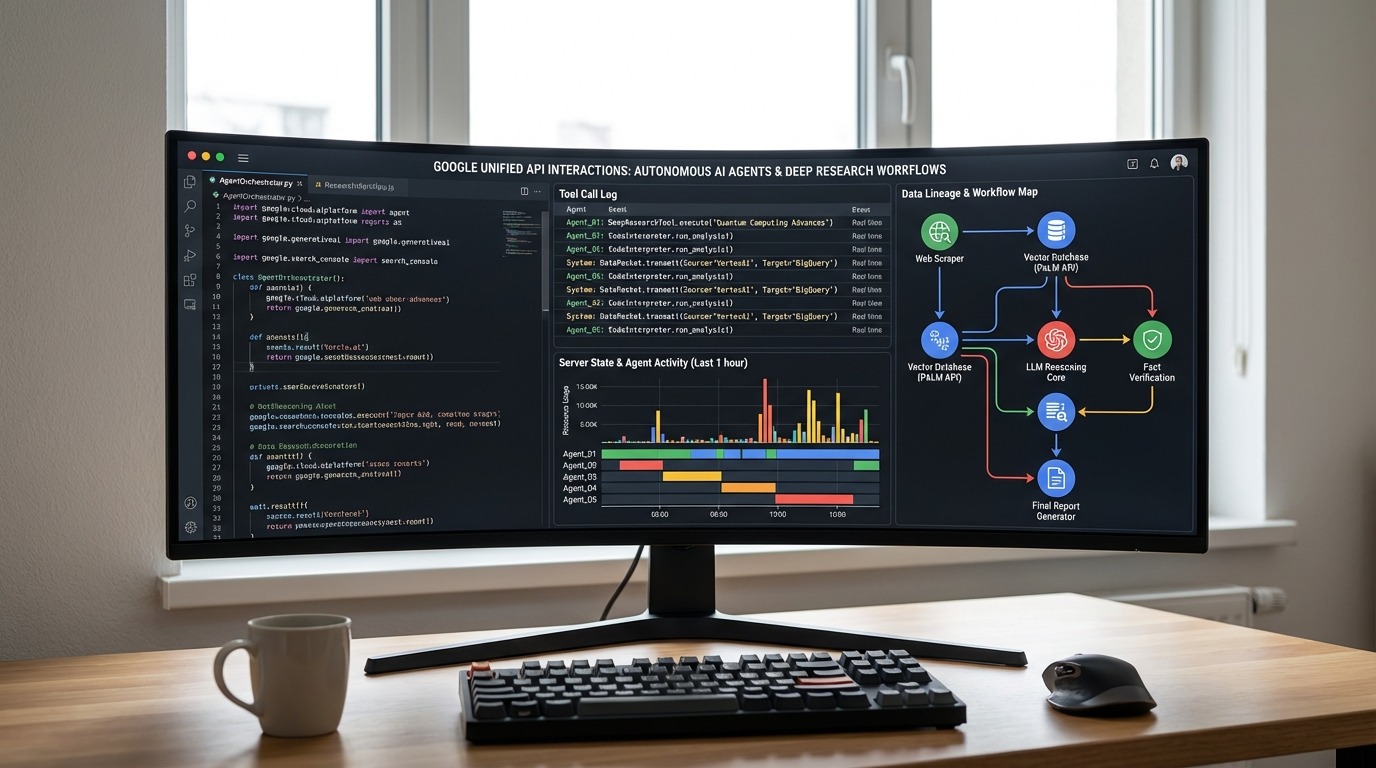

Au cœur de l’annonce, l’API Interactions rassemble les capacités des modèles Gemini et la logique d’agents en un seul endpoint. Cette approche réduit les coûts d’intégration et limite les frictions entre prototypage et production. Elle s’adresse aux équipes qui doivent enchaîner génération de texte, recherche contextualisée et appels d’outils externes sans perdre l’historique ni dégrader la traçabilité.

Conception unifiée, gestion d’état et tâches longues

Concrètement, le serveur gère l’état conversationnel et l’entrelacement messages/raisonnements/appels d’API. Ainsi, une tâche longue, comme un audit de conformité sur 1 000 pages PDF, peut s’exécuter en arrière-plan sans casser le fil de l’agent. L’API consolide les résultats, logge les décisions et produit des sorties structurées. Grâce à cette logique, les développeurs évitent la prolifération de micro-services dédiés à la mémoire, au scheduling et à la reprise après incident.

Le support natif de MCP (Model Context Protocol) simplifie la connexion d’outils privés. Par exemple, un service interne d’inventaire peut être exposé comme “tool” sécurisé. Ensuite, l’agent appelle la fonction, récupère des identifiants de lots, puis alimente un rapport produit sans divulguer d’informations sensibles. Cette granularité d’autorisations soutient des architectures zero-trust et évite l’exfiltration de données.

ADK, A2A et passerelle vers un écosystème d’agents

L’Agent Development Kit (ADK) facilite la création d’agents spécialisés. De plus, le protocole Agent2Agent (A2A) rend possible la coordination entre agents, par exemple un agent “veille réglementaire” qui alimente un agent “synthèse exécutive” chargé d’émettre un mémo à la direction. Grâce à l’API Interactions, ces échanges restent tracés et auditables, ce qui aide à satisfaire des exigences de conformité.

Un exemple illustre la promesse. Asteria Labs, fabricant d’équipements IoT, met en place un agent d’investigation qualité. D’abord, il interroge l’ERP via MCP, puis il agrège des tickets de maintenance. Ensuite, il classe les incidents, recherche des bulletins de vulnérabilité publics et rédige un plan d’action priorisé. Ce flux, auparavant morcelé, tient désormais en une unique séquence orchestrée par l’API.

En définitive, l’architecture unifiée apporte une gouvernance technique lisible et une meilleure robustesse aux erreurs. Cette base prépare l’arrivée d’agents plus autonomes, tout en gardant des garde-fous explicites.

Recherche Profonde repensée : navigation, citations granulaires et synthèses fiables

La Recherche Profonde de Google évolue en un agent de recherche itératif. L’agent décompose la demande, explore des sources variées, identifie les angles morts, puis reformule la requête. Ce cycle se répète jusqu’à atteindre une couverture satisfaisante. Grâce à Gemini 3 Pro, présenté comme le modèle le plus factuel de la gamme, le système réduit les hallucinations et renforce l’attribution aux sources.

Du web public aux documents privés, une stratégie multi-sources

L’agent analyse à la fois des pages web, des PDF internes, des CSV et des documents d’entreprise. Ensuite, il synthétise des éléments concrets avec des citations dites ‘granulaires’. Chaque insight renvoie à un paragraphe ou un tableau précis, ce qui aide les équipes légales et data à vérifier l’origine d’une affirmation. Pour un cabinet de conseil, cette traçabilité change la donne dans les livrables clients.

Pour évaluer ses progrès, Google publie DeepSearchQA, un benchmark de 900 tâches multi-étapes. Sur ce test, Deep Research atteint un score de 66,1%. Bien sûr, un benchmark n’épuise pas la complexité du réel. Toutefois, ce score corrobore les gains observés sur des scénarios concrets, comme des études de marché pharmaceutique ou des analyses concurrentielles B2B.

Intégrations produits et cas d’usage opérationnels

Google prévoit d’intégrer cette version dans Search, Finance, l’application Gemini et NotebookLM. Pour une équipe Produit, l’agent peut surveiller les dépôts Git, l’actualité sectorielle et des bases de brevets, puis proposer un plan de roadmap appuyé par des sources. Pour un service Achats, il peut cartographier les fournisseurs, croiser les coûts, les délais et les incidents de qualité, avant de recommander un sourcing alternatif.

Un retailer européen, baptisé Orion Commerce, a testé l’agent sur la veille pricing. D’abord, l’agent collecte des prix sur des centaines de sites. Puis, il détecte les écarts significatifs et simule l’impact sur les marges par catégorie. Enfin, il propose des ajustements et des messages pour l’équipe marketing. Ce type d’automatisation, soutenu par des sources vérifiables, réduit les cycles de décision.

Cette profondeur de navigation annonce un futur où la recherche n’est plus un simple classement de liens, mais une enquête documentée et réplicable. C’est un déplacement majeur dans la chaîne de valeur de l’innovation décisionnelle.

Impact pour les développeurs et les entreprises : interopérabilité, sécurité et ROI mesurable

L’API Interactions cible la productivité des équipes techniques. Grâce à la gestion d’état côté serveur, les développeurs se concentrent sur la logique métier. Par conséquent, le time-to-value diminue. Les coûts d’orchestration et de maintenance baissent aussi, car l’infrastructure évite de réimplémenter mémoire, files d’attente et reprise de tâches.

Cas d’usage sectoriels à haute valeur

Dans la finance, un agent de Recherche Profonde peut agréger des documents réglementaires, vérifier des ratios, puis générer un mémo de conformité. Dans l’industrie, un agent “qualité usine” relie capteurs, tickets et retours SAV pour expliquer une dérive de production. Dans la santé, un agent “evidence synthesis” compile des publications cliniques et signale les biais méthodologiques. Ces scénarios illustrent la montée en gamme des agents, qui passent du chatbot à l’assistant d’enquête.

Le commerce et le support client profitent aussi de cette évolution. Un agent connecté à un CRM peut prioriser les tickets, suggérer des réponses, puis produire un compte rendu traçable. Les directions Care cherchent déjà des cadres de fidélisation adaptés à ces nouveaux flux; un retour d’expérience récent sur le suivi clientèle et la fidélisation montre l’intérêt de combiner IA et pilotage d’indicateurs relationnels.

Sécurité, gouvernance et conformité

La question de la sécurité reste centrale. Avec MCP et des contrôles d’accès fins, l’agent n’exécute que des actions autorisées et loguées. Les journaux incluent la chaîne de raisonnement, ce qui aide à auditer les décisions. Ensuite, des garde-fous empêchent l’agrégation de données sensibles en dehors des périmètres définis. Ce niveau d’auditabilité séduit les secteurs soumis à des normes strictes.

Pour structurer un déploiement, les équipes Produit s’appuient sur des méthodes allégées. Un cadre comme un Lean Canvas de démarrage clarifie la proposition de valeur, les segments cibles et les risques principaux. En combinant ce cadrage avec des preuves de valeur rapides, les sponsors obtiennent des jalons concrets, plutôt que de longs paris technologiques.

Au final, l’angle ROI se renforce lorsque les agents livrent des décisions étayées, des temps de cycle réduits et des traces vérifiables. C’est la condition pour un passage à l’échelle durable.

Google vs OpenAI : une synchronisation stratégique autour du moteur de recherche et des agents

Le duel entre Google et OpenAI s’intensifie. Les deux acteurs annoncent leurs avancées le même jour, signe d’une stratégie de calendrier assumée. D’un côté, Google pousse l’API Interactions et la Recherche Profonde. De l’autre, OpenAI met en avant GPT-5.2 et la vision SearchGPT, tournée vers un moteur de recherche conversationnel.

Deux voies vers la même promesse : fiabilité et action

Google mise sur l’agent de recherche itératif, les citations granulaires et une intégration serrée aux produits. Pendant ce temps, OpenAI propose une interface qui répond directement à des requêtes complexes, avec une ambition de navigation et d’exécution d’actions. Les différences tiennent aux choix d’orchestration, aux garanties de source et au degré d’ouverture des écosystèmes.

Pour un utilisateur final, l’arbitrage portera sur trois facteurs. D’abord, la précision des réponses et la possibilité de vérifier les sources. Ensuite, la fluidité d’intégration dans les workflows existants. Enfin, le coût total d’exploitation, incluant sécurité et conformité. Ces critères pèseront davantage que la seule performance brute sur un benchmark.

Les entreprises observent aussi la capacité des deux camps à fédérer un écosystème d’événements, de SDK et de partenaires. À ce titre, un rendez-vous comme un sommet dédié aux interactions numériques éclaire les approches d’orchestration et d’expérience utilisateur centrée agents.

À court terme, la convergence est probable. Les agents devront chercher, raisonner, citer, puis agir dans des systèmes tiers. La meilleure plateforme sera celle qui délivre cette boucle en continu, sans sacrifier la vérifiabilité.

Mettre en œuvre API Interactions et Recherche Profonde : plan d’action pragmatique

La transformation se gagne étape par étape. Un guide 30-60-90 jours aide à cadrer l’ambition, sécuriser la gouvernance et livrer de la valeur visible. Ce plan s’applique à une PME comme à une ETI, avec des ajustements de périmètre et de contrôle.

Plan 30-60-90 jours et mesures d’impact

Dans les 30 premiers jours, l’équipe identifie un flux coûteux et répétitif, avec des données propres et des conditions d’accès claires. Ensuite, elle configure un premier agent avec l’API Interactions et des outils MCP en sandbox. Elle trace les décisions et prépare des tests d’acceptation. Ce cadrage limite le risque et crée un socle d’apprentissage.

- Définir un objectif métier clair et un KPI unique (délai, coût, taux d’erreur).

- Cartographier les sources (web, PDF, bases internes) pour la Recherche Profonde.

- Activer des outils MCP avec des permissions minimales et des secrets gérés.

- Rédiger des prompts d’audit, avec attentes et critères d’acceptation précis.

- Mettre en place des journaux détaillés et une politique de révision hebdomadaire.

Entre J30 et J60, l’équipe élargit le périmètre. Par ailleurs, elle intègre la génération de rapports avec citations granulaires. Les utilisateurs pilotes donnent un feedback sur la lisibilité, la source des données et la qualité des recommandations. Ensuite, la cellule sécurité teste les dérives possibles et renforce les contrôles d’accès.

De J60 à J90, le dispositif passe en pré-production. L’agent gère des tâches longues, puis priorise les cas complexes. En parallèle, un comité métier arbitre l’extension à d’autres services. Les métriques d’impact incluent le temps de cycle, le taux de réouverture des tickets et la part de décisions documentées. Cette boucle d’amélioration continue garantit la crédibilité de la démarche.

Exemple fil rouge : NovaCart et la veille prix

NovaCart, distributeur multimarques, adopte ce plan. D’abord, l’agent parcourt le web, télécharge des fiches produits et extrait des prix. Ensuite, il confronte ces données avec l’historique interne, puis propose un ajustement par famille. Enfin, il génère un mémo pour la direction, avec des liens précis vers les sources. Les équipes gagnent en réactivité et en confiance, car chaque recommandation est justifiée.

À l’issue de 90 jours, NovaCart obtient une réduction du temps d’analyse et un meilleur alignement marketing/achats. L’agent devient un partenaire de décision, pas un simple générateur de texte. C’est exactement la promesse de l’innovation agentique : rendre l’action plus rapide et plus sûre.

On en dit quoi ?

La stratégie de Google pose un jalon solide. L’API Interactions simplifie l’orchestration, tandis que la Recherche Profonde renforce la vérifiabilité. Face à OpenAI, l’avantage ira au camp qui maîtrisera la boucle “chercher, raisonner, citer, agir” avec le meilleur contrôle des données. Pour les équipes, le moment est venu de piloter des agents utiles, traçables et branchés sur les systèmes réels. L’IA progresse lorsqu’elle prouve, pas seulement quand elle promet.

Spécialiste en technologies et transformation numérique, fort d’une expérience polyvalente dans l’accompagnement d’entreprises vers l’innovation et la dématérialisation. Âgé de 26 ans, passionné par l’optimisation des processus et la gestion du changement.